近日,我组和新加坡国立大学Sea-NExT Joint Lab合作论文“Fine-Grained Scene Graph Generation with Data Transfer”被录用为ECCV 2022 Oral。欧洲计算机视觉国际会议 (European Conference on Computer Vision, 简称ECCV)在世界范围内每两年召开一次,是计算机视觉领域三大顶级会议之一。根据ECCV 2022官方公布的数据显示: 本次会议共有5803篇投稿,录取1650篇 (28%录取率),其中158篇被推荐做口头报告 (2.7%)。以下为论文介绍:

题目: Fine-Grained Scene Graph Generation with Data Transfer

论文链接: https://arxiv.org/abs/2203.11654

代码地址:https://github.com/waxnkw/IETrans-SGG.pytorch

作者: 张傲*,姚远*,陈乾瑜,吉炜,刘知远,孙茂松,Tat-Seng Chua (*代表共同第一作者)

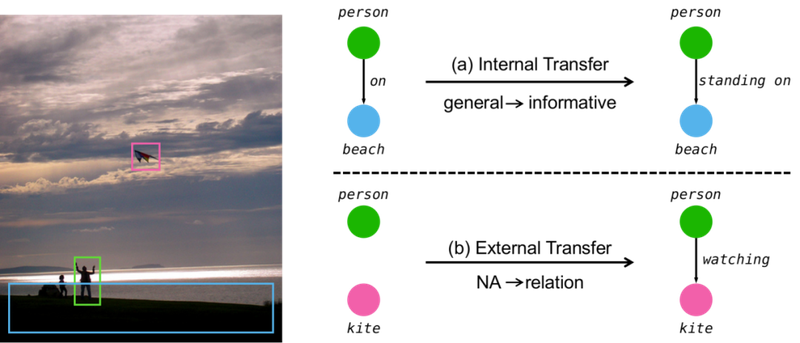

摘要: 场景图生成旨在检测图像中的(主语,谓语,宾语)三元组,是连接视觉和语言的重要中间任务。但是由于标注中的长尾分布和语义多样性问题,现有的场景图生成模型趋向于仅预测简单、低信息量的谓语 (比如: on,at)。这种预测上的低信息量极大程度的限制了场景图生成模型在下游任务中的应用。为了应对这些问题,我们提出了一种即插即用的内部+外部转移方法 (Internal and External Data Transfer, 简称IETrans)。我们的IETrans方法可以辅助不同种类的场景图生成模型自动修正现有训练集。通过创建一个标注充足,一致性良好的增强版训练集,我们的方法可以帮助现有模型生成更有信息量的场景图。比如,在常规的50类谓语分类场景中,我们的方法可以使得Neural Motif模型的平均召回率指标翻倍。此外,我们的方法还可以扩展到更有挑战性的1807类谓语的场景图检测任务中。正常训练的Neural Motif模型仅能在谓语分类场景下产生47个类别上的正确预测。而通过使用我们的方法,同样的模型可以产生467个类别上的正确预测。