近日,著名论文摘要网站 PaperDigest 发布了各领域最有影响力的论文列表,我组共有 9 篇论文分别入选了 AAAI、ACL、IJCAI、EMNLP 最有影响力论文列表。PaperDigest 通过分析在国际重要会议上发表的所有论文,评选出每年最具影响力的 10 篇论文。

我组入选的 9 篇论文分别为:

AAAI

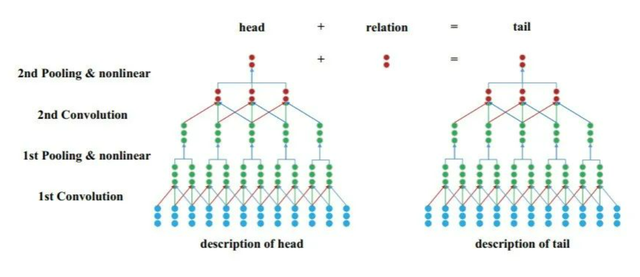

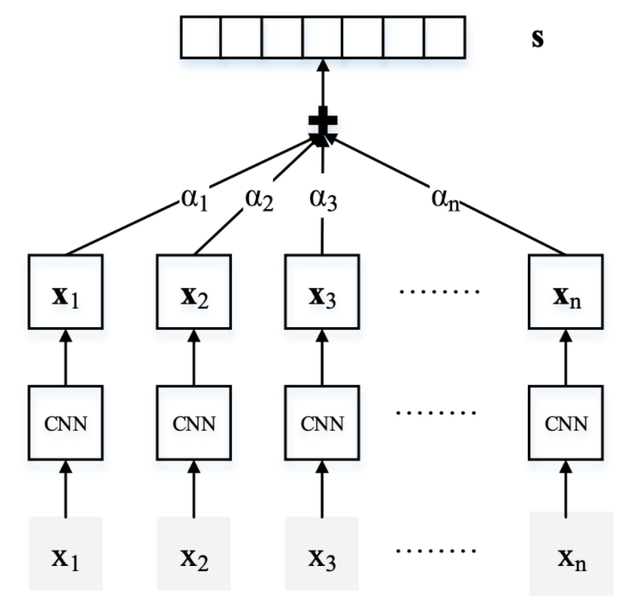

- Representation Learning Of Knowledge Graphs With Entity Descriptions,位列 AAAI 2016 年最具影响力论文第九名。目前大部分的知识表示学习方法都集中于三元组中的实体和关系,而忽视了知识图谱中对实体的描述信息。该论文提出一种新颖的知识表示学习方法 DKRL。我们利用两种编码器来编码实体描述的文本信息,分别是连续词袋模型 CBOW 和 CNN,之后利用三元组和描述信息来共同的学习知识表示。这种方法甚至有能力可以根据文本的描述信息构建知识图谱中不存在的实体的知识表示。

论文链接:

https://ojs.aaai.org/index.php/AAAI/article/view/10329

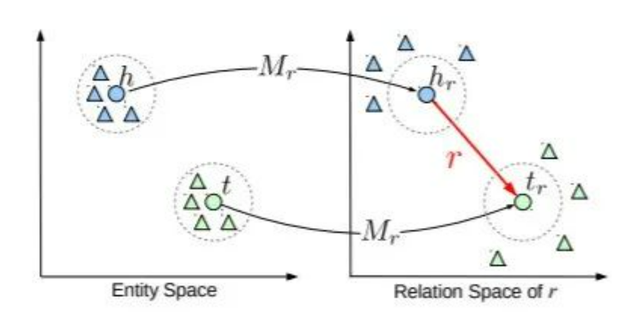

- Learning Entity and Relation Embeddings for Knowledge Graph Completion(与三星合作),位列 AAAI 2015 年最具影响力论文第二名。该论文针对知识图谱中复杂关系的建模问题提出了一种基于空间投影的知识表示学习方法。当时知识表示学习中最具代表性的模型为 TransE 模型,TransE 提出对关系的平移性质进行建模,将知识图谱中的实体与关系映射到统一的语义空间中,模型效率和性能均较以往模型有显著提升。然而,TransE 无法很好地处理 1 对多和多对多等复杂类型关系。针对这个问题,该论文为了改进对复杂关系的建模能力,提出一种基于空间投影的 TransR 模型,实现实体与关系在不同语义空间的表示,对于每个实体对在不同关系空间中对关系的平移性质进行建模,能够显著提升对复杂关系的表示性能。

论文链接:

https://ojs.aaai.org/index.php/AAAI/article/view/9491

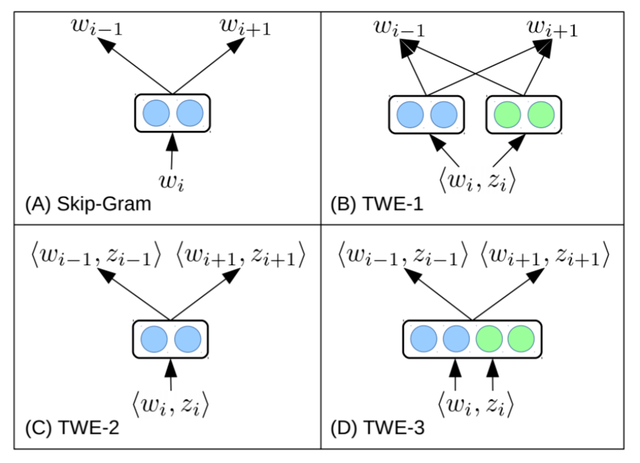

- Topical Word Embeddings(与新加坡国立大学合作),位列 AAAI 2015 年最具影响力论文第六名。大多数词嵌入模型通常使用单个向量来表示每个单词,因此这些模型无法区分同音异义和的一词多义的情况。为了增强判别性,我们采用潜在的主题模型为文本语料库中的每个词分配主题,并基于词和主题来学习主题词嵌入(TWE),这样我们可以灵活地获得情景词嵌入,来衡量情景中单词相似性。我们还可以构建文档的向量表示,这比一些广泛使用的文档模型(如潜在主题模型)更具有表现力。在实验中,我们评估 TWE 模型的两个任务:情景单词相似性和文本分类。实验结果表明,我们的模型比典型的词嵌入(包括基于上下文的词相似度的多种原型版本)表现更好,同时也优于文本分类的潜在主题模型和其他代表性文档模型。

论文链接:

http://nlp.csai.tsinghua.edu.cn/~lzy/publications/aaai2015_twe.pdf

ACL

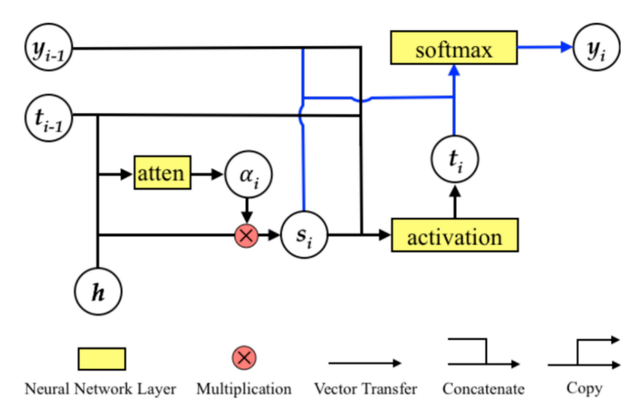

- Neural Relation Extraction With Selective Attention Over Instances,位列 ACL 2016 年最具影响力论文第六名。该论文针对远程监督关系抽取方法中的噪音问题,提出了基于样例级别选择注意力的神经网络关系抽取模型。主流关系抽取方法一般基于远程监督假设,通过对齐知识图谱中已有的关系事实和未经标注的自由文本来自动生成训练数据。然而,远程监督假设中极强的启发式规则产生的训练数据中往往存在大量噪音。针对这个问题,该模型提出样例级别选择性注意力机制来综合利用包含同一实体对的所有句子中的有效信息进行关系抽取。模型通过计算关系表示和句子表示之间的语义关联,为每个句子自动计算权重。通过让那些不能反映关系信息的句子的注意力(权重)变小,能够降低噪音标注对关系抽取训练的影响,显著提升关系抽取性能。

论文链接:

https://www.aclweb.org/anthology/P16-1200v2.pdf

- Modeling Coverage for Neural Machine Translation(与华为合作),位列 ACL 2016 年最具影响力论文第九名。注意力机制通过同时学习对齐和翻译,增强了最新的神经机器翻译模型(NMT)。然而,它往往会忽略历史的对齐信息,从而导致过翻译(overtranslation)和欠翻译(undertranslation)的问题。为解决此问题,我们在本文中提出了基于覆盖率(coverage)的 NMT。我们维护一个覆盖向量,以跟踪关注历史记录。覆盖向量被送到注意力模型,以帮助调整未来的注意力,这使 NMT 系统可以更多地考虑未翻译的源端词。实验结果表明,与标准的基于注意力的 NMT 模型相比,该方法可显着提高翻译质量和对齐质量。

论文链接:

https://www.aclweb.org/anthology/P16-1008.pdf

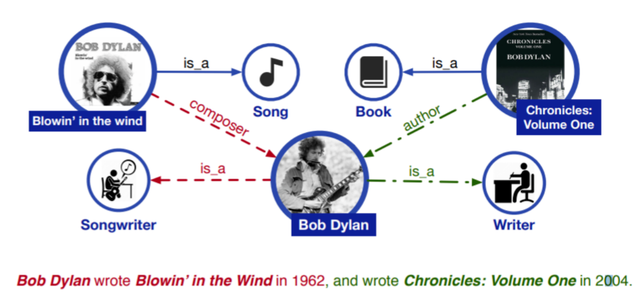

- ERNIE: Enhanced Language Representation with Informative Entities(与华为合作),位列 ACL 2019 年最具影响力论文第五名。NLP 表示模型如 BERT 的预训练模型能够在大量的纯文本语料中捕获丰富的语义信息,并且通过微调改进 NLP 任务的效果。然而,已存在的预训练语言模型很少考虑将知识图谱的结构化信息融入其中,从而提高语言的理解。我们认为知识图谱中的信息实体能够增强语言表示。在这篇论文中,我们利用了大规模的语料信息和知识图谱,去训练一个增强的语言表示模型,它能够同时利用词汇、语义和知识信息。实验结果表明, ERNIE 效果很好,在各项知识驱动的任务中都超过了 BERT 模型。

论文链接:

https://www.aclweb.org/anthology/P19-1139.pdf

IJCAI

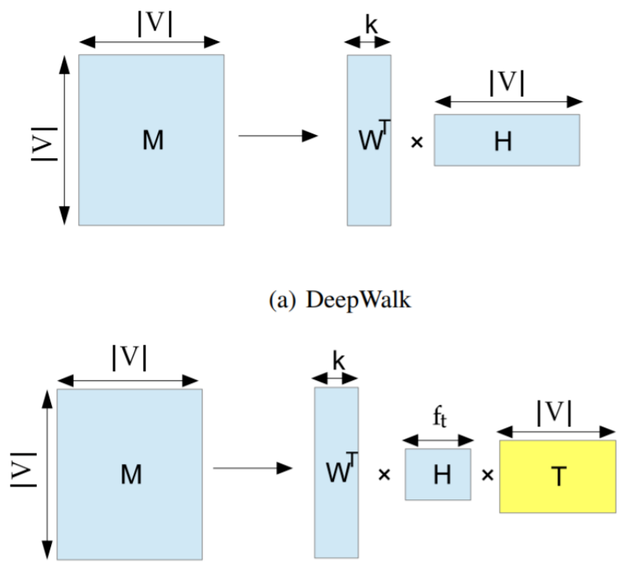

- Network Representation Learning with Rich Text Information(与HTC合作),位列 IJCAI 2015 年最具影响力论文第四名。表征学习已证明其在许多任务中的有效性,例如图像分类和文本挖掘。网络表示学习旨在学习每个对象的分布式矢量表示网络中的节点,这也日益被认为是网络分析的重要方面。大多数网络表示学习方法研究网络结构以进行学习。实际上,网络节点包含丰富的信息(例如文本),无法很好地与典型表示学习方法的算法框架一起应用。通过证明最先进的网络表示方法 DeepWalk 实际上等效于矩阵分解(MF),我们提出了与文本相关的 DeepWalk(TADW)。在矩阵分解的框架下,TADW 将节点的文本特征合并到网络表示学习中。我们通过将我们的方法和各种基线方法应用于节点的多类分类任务来对其进行评估。实验结果表明,该方法在所有三个数据集上均优于其他基准,特别是在网络噪声大,训练率小的情况下。

论文链接:

https://www.ijcai.org/Proceedings/15/Papers/299.pdf

EMNLP

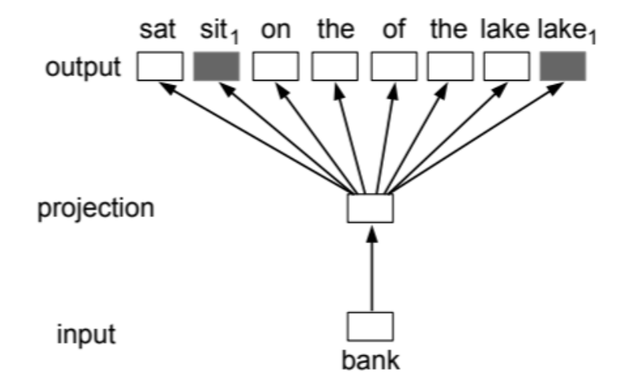

- A Unified Model for Word Sense Representation and Disambiguation,位列 EMNLP 2014 年最具影响力论文第十名。大多数词向量表示的方法假设每一次词仅有一个语义空间中的向量表示。考虑到词的多义性是一个普遍现象,这一假设并不合理,词义消歧等任务也尝试解决这一问题。在本篇论文中,我们提出了一个词向量表示和词义消歧的联合训练模型,通过给每一个词义(而不是词)指定一个向量表示,解决多义性的问题。这一模型基于词向量表示与词义消歧可以互相帮助的猜测:(1)好的词向量表示能够有效捕捉到词的多义性,帮助词义消歧;(2)好的词义消歧模型提供词的多义信息,帮助训练词向量。实验结果表明,我们的方法同时提升了基于上下文的词向量表示和词义消歧模型的表现。

论文链接:

https://www.aclweb.org/anthology/D14-1110.pdf

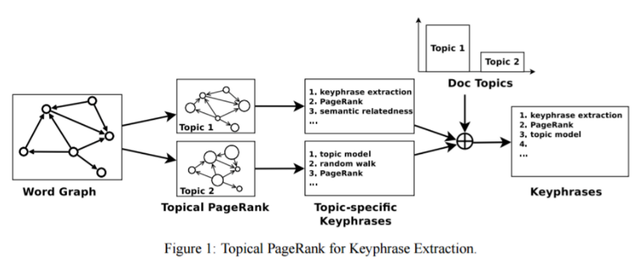

- Automatic Keyphrase Extraction Via Topic Decomposition,位列 EMNLP 2010 年最具影响力论文第六名。目前的基于图模型排序的关键词抽取方法对每一个词仅计算单一分数。考虑到文档和词语都可以表示成多个语义的混合,我们提出将传统的随机游走方法解耦成多个随机游走过程,每一个随机游走过程对应一种不同的主题。随后我们根据不同的主题,在词图上构建 PageRank 模型,来衡量词语对每个主题的重要程度。给定每个文档的主题,我们可以计算出每一个词语对每个文档特定主题的分数,作为关键词评分。实验结果表明,我们的模型在两个数据集上取得了目前关键词抽取的最好效果。

论文链接:

https://www.aclweb.org/anthology/D10-1036.pdf

入选论文均为我组长期耕耘的自然语言处理方向,感谢学界同仁关注与支持!

完整列表见PaperDigest网站:

AAAI 最有影响力论文列表

https://www.paperdigest.org/2021/02/most-influential-Aaai-papers/

ACL 最有影响力论文列表

https://www.paperdigest.org/2021/02/most-influential-acl-papers/

IJCAI最有影响力论文列表

https://www.paperdigest.org/2021/02/most-influential-acl-papers/

EMNLP最有影响力论文列表

https://www.paperdigest.org/2021/02/most-influential-Emnlp-papers/