2019年7月1日,清华大学人工智能研究院自然语言处理与社会人文计算研究中心(以下简称中心)成立仪式在清华大学FIT楼举行。清华大学副校长、清华大学人工智能研究院管委会主任尤政院士,清华大学人工智能研究院院长张钹院士出席成立仪式并共同为中心揭牌。清华大学人工智能研究院院长助理朱军教授主持成立仪式。

尤政院士致辞

尤政院士在致辞中指出,人类语言是人类智能的本质体现,更是人工智能技术当下和未来发展的战略制高点。清华大学是国内最早开展自然语言处理的单位之一,经过四十年的不懈努力,已经发展成国内外自然语言处理研究的一方重镇。中心的成立对于推动清华大学人工智能的深入发展具有十分重要的意义。自然语言处理与社会科学及人文科学相结合,具有大跨度学科交叉的性质,既是人工智能研究本身的积极拓展,也是对传统学科在人工智能时代的守正出新。希望中心能够凝聚清华自然语言处理研究力量,加强与人文社科学科的交叉合作,开展具有世界水平的自然语言处理基础理论研究和关键技术创新,服务于清华与国家的人工智能发展战略。

张钹院士致辞

张钹院士代表清华大学人工智能研究院致辞。他指出语言是人类智能的重要标志,机器自然语言理解是人工智能的终极目标。清华大学在自然语言处理方面有着深厚的研究积淀,1978年成立人工智能与智能控制教研组时,自然语言处理就是其中的重要研究方向之一,在黄昌宁教授领导下迅速发展成为国内领军的研究单位。新成立的中心将致力于实现自然语言处理与人文社科的深度融合,从语言、社会学、人文学等多个角度理解人类智能的本质,是研究院人工智能基础研究的重要组成部分。希望中心再接再厉,在自然语言处理与社会学、人文学的交叉研究上形成特色,引领我国自然语言处理和社会人文计算研究领域的发展。

清华大学自然语言处理研究方向开拓者黄昌宁教授(左)在成立仪式上

朱军教授主持仪式

尤政院士与张钹院士为中心揭牌

中心主任由清华大学人工智能研究院常务副院长孙茂松教授担任。在成立仪式上,尤政院士和张钹院士向孙茂松教授颁发了中心主任聘书。中国中文信息学会原理事长、中国工程院院士倪光南,滑铁卢大学讲座教授、加拿大皇家科学院院士李明,微软亚洲研究院副院长、国际计算语言学会会长周明,英国帝国理工学院数据科学研究所所长、英国皇家工程院院士郭毅可被聘为中心学术顾问。尤政院士和张钹院士现场向出席会议的李明院士和周明副院长颁发了中心学术顾问聘书。

孙茂松教授被聘为中心主任

李明院士、周明博士被聘为中心学术顾问

在成立仪式上,李明院士、周明副院长以及清华大学法学院院长申卫星教授、清华大学人文学院副院长刘石教授先后发言,对中心的成立表示衷心祝贺。

申卫星教授发言

刘石教授发言

中心成立仪式合影

嘉宾合影

成立仪式之后举行了自然语言处理前沿学术报告与开源成果发布会,分别由中心常务副主任刘洋副教授和中心主任孙茂松教授主持。

李明院士做特邀报告

李明院士做了题为《第二代对话机器人》的特邀报告。报告指出缺乏理解能力、缺乏学习能力、被动地“人云亦云”是第一代聊天机器人的主要缺陷,其原因在于目前的深度学习技术还不具备理解和使用人类语言所必需的概念抽象和逻辑推理能力。他认为实现理解和学习是第二代聊天机器人的主要目标,机器人只有通过自动学习和社会参与才能获得不断地成长,从而具备更强的运用人类语言的能力。

周明博士做特邀报告

周明博士做了题为《关于神经网络自然语言处理的思考》的特邀报告。报告对基于神经网络的自然语言处理的研究进展进行了系统地回顾与总结,指出自然语言处理目前面临着深度学习计算成本高昂、大规模标注数据稀缺、难以实现真正的理解与推理等关键挑战。他认为未来应当从计算能力、数据资源、模型算法、系统应用、人才培养、交叉合作等六个方面进一步推动自然语言处理的发展。

中心成员刘洋、矣晓沅和刘知远分别介绍了在数据驱动的机器翻译、基于深度学习的中文诗歌自动生成系统以及大规模自然语言预训练模型等方面的最新研究成果,并发布了相关开源工具、数据与模型。

刘洋副教授介绍开源成果THUMT

THUMT是一个基于深度学习的机器翻译系统。该系统使用了数据驱动的机器翻译技术,具备良好的语言无关性,在具备训练数据的条件下可以迅速为新语种部署系统。本次开源成果公布了在TensorFlow平台上开发的新版本,采用了主流的Transformer模型,集成了目前最新的神经机器翻译技术,具有训练速度快(支持多机多卡并行)、显存占用低(支持单精度浮点数计算)、翻译性能高(与国际机器翻译开源软件相比位居前列)、易于可视化分析(支持层级相关反馈算法)等优点。此外还开放了70万句对的句级对齐汉英平行语料库和4万句对的词级对齐汉英平行语料库。项目网址:thumt.thunlp.org 在线翻译系统网址:translate.thumt.cn

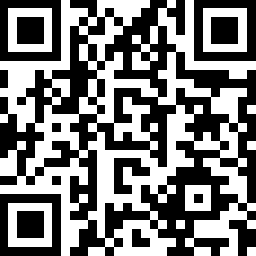

THUMT系统网址

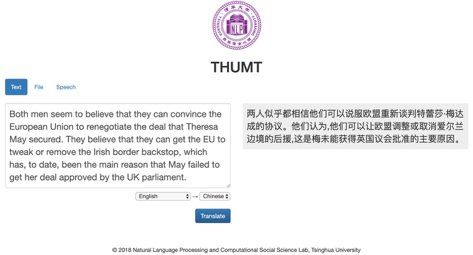

THUMT翻译界面

开源项目网址

矣晓沅博士生介绍开源成果THUAIPoet

THUAIPoet (九歌) 是一个基于深度学习的中文诗歌自动生成系统,支持集句诗、绝句、藏头诗、词等不同体裁诗歌的在线生成。此次成果发布开源了系统中的无监督风格诗歌生成模型StylisticPoetry源码(相关论文发表于EMNLP 2018),能够在无标注数据集上进行任意数量的风格解耦控制。此外还发布两个人工标注的诗歌数据集(诗歌质量数据集和诗歌情绪数据集),以及国内外诗歌生成相关的主要论文列表。GitHub网址:github.com/thunlp-aipoet 九歌APP网址:jiuge.thunlp.cn

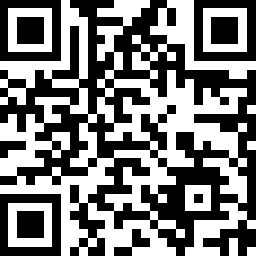

九歌APP网址

九歌诗词创作系统界面

GitHub开源网址

刘知远副教授介绍开源成果OpenCLaP

OpenCLaP(Open Chinese Language Pre-trained Model Zoo)是一个多领域中文预训练模型仓库。通过在多领域大规模中文文本的预训练,这些预训练模型可以在下游任务上进行微调以提高任务性能。本次开源成果公布了基于法律文本和百度百科千万级文档的预训练模型,支持最大512长度的文本输入适配多种任务需求。未来还将持续加入更多更强的预训练模型,如增加更多训练语料,引入大规模知识,使用全词覆盖策略等。GitHub网址:github.com/thunlp/OpenCLaP 项目网址:zoo.thunlp.org

OpenCLaP网址

GitHub开源网址

中心是清华大学人工智能研究院设立一周年之际成立的第八个研究中心。中心将紧密围绕人类语言所体现的人类智能本质,重点研究鲁棒、可解释的自然语言处理方法与技术,深入探索语言理解与生成技术在社会人文计算领域的应用,努力建设以中文为核心、覆盖多种语言、从词法到篇章的全流程自然语言处理技术框架与计算平台,力争产出以智能创作、智能语言学习、智能教育、智能司法为代表的有国际影响力和重大民生意义的社会人文计算研究成果。

本中心的前身是清华大学计算机系自然语言处理课题组,早在上个世纪七十年代末就在黄昌宁教授的带领下从事自然语言处理研究工作,是国内开展相关研究最早、深具影响力的科研单位,同时也是中国中文信息学会(全国一级学会)计算语言学专业委员会的挂靠单位,孙茂松教授现任该专业委员会的主任。